这是一个AI的时代,这是一个算力的时代。遗憾的是,我们已经无缘接触到最先进的AI硬件和算力,用着H20这样阉割两次的N卡,还要支付上百亿元的费用,实在憋屈。

面对持续上涨的AI算力需求,我们唯有发展自己的国产方案,发展自己的大规模AI算力集群,才能突破围追堵截,走上康庄大道。

说到这里,很多人或许会第一时间想到华为,在美国制裁下顽强屹立突破的中国企业标杆,昇腾910B在AI算力领域也取得了一定的成就。

当然了,中国只依靠一个华为是不够的。中国的AI生态需要遍地开花,才有可能多点突破,让生态更繁荣。

目前来看,摩尔线程以全功能GPU走通用计算路线是另一条希望之路,尤其是它已经成为华为之外,另一家可以实现千卡千亿参数大模型训推的全国产AI芯片公司。

说起来,大家对摩尔线程并不陌生,其堪称中国自主GPU最大的希望,但很多人对摩尔线程的认知还停留在国产游戏显卡,其实不然,摩尔线程在AI上也实力突出。

自成立以来,摩尔线程做的就是通用GPU,跟英伟达一样,除了图形渲染,也能用于AI人工智能加速、科学计算。

经过三年多潜心发展,摩尔线程在AI GPU方面已经展现了强劲的实力,构建了一张从芯片、板卡、服务器,到集群、软件栈的全栈AI智算产品版图,并且已经多点落地、处处开花。

比如和清华系AI大模型公司无问芯穹的合作。

摩尔线程是第一家接入无问芯穹,并成功完成千卡级别大模型训练的国产GPU公司。

摩尔线程的“夸娥”(KUAE)千卡智算集群,已与无穹Infini-AI大模型开发与服务平台完成系统级融合适配,并完成了LLama2 700亿参数大模型的训练测试。近期,双方又完成了“MT-infini-3B” 3B(30亿参数)大模型的实训。

这意味着什么呢?这是行业首个基于国产GPU芯片的从0到1的端到端大模型实训案例。夸娥也成为业内首个成功跑通并完整运行国产大模型的千卡集群。

无问芯穹联合创始人兼CEO夏立雪表示力挺:

经过无问芯穹Infini-AI平台的实训与联合优化工作验证,摩尔线程夸娥千卡智算集群在精度、性能、易用性和算力利用率上均有优异表现,而且在实训中实现了长时间稳定训练不中断,可以为千亿参数级别大模型训练提供持续高效的高性能算力支持。

另外,滴普科技、实在智能等也基于摩尔线程的夸娥千卡智算集群,成功完成了不同参数量级的大模型分布式训练测试,效率、精度、稳定性都相当完美。基于摩尔线程夸娥千卡智算集群,滴普科技成功完成了700亿参数LLaMA2大语言模型的预训练测试,训练时长共计77小时,全程无故障连续运行,集群训练稳定性达到100%。

夸娥(KUAE)是摩尔线程推出的智算中心全栈解决方案,可以说,为AI算力集群取这么一个名字,充分展现了独属于中国人的坚忍不拔和浪漫情怀。

出自《愚公移山》:“帝感其诚,命夸娥氏二子负二山,一厝朔东,一厝雍南。自此,冀之南,汉之阴,无陇断焉。”

夸娥解决方案的基本节点是大模型智算加速卡MTT S4000组成的双路八卡GPU服务器“MCCX D800”,以软硬件一体化交付、开箱即用的方式,高可靠地解决大规模GPU算力的建设和运营管理问题。

MTT S4000是摩尔线程新一代专为AI大模型打造的智算加速卡,基于其自主研发的第三代MUSA架构。

利用自研的MTLink互连技术,MTT S4000可以高效千卡并行,线性加速比高达91%以上。

最为关键的是,摩尔线程拥有自研的全功能GPU MUSA统一系统架构,包括指令集架构、MUSA编程模型、驱动、运行时库、算子库、通讯库、数学库等,而且充分兼容CUDA软件生态,代码可以几乎零成本迁移,也无需担心未来的可用性问题。

MTT S4000不但可用于大规模AI计算,还具备领先的图形渲染能力、视频编解码能力、8K超高清显示能力。这使得它可为数字孪生、云游戏、云渲染、数字内容创作等场景提供支持,并配合大模型推理能力,服务于AIGC等多模态业务场景。

从2024年的趋势来看,多模态需求将快速崛起,对国产芯片来说也同样如此。

MCCX D800作为AI大模型训推一体机,是专为支持MTT S4000大模型智算加速卡充分发挥其训练与推理性能、稳定性、可靠性的服务器系统,同时兼容主流GPU软硬件生态。

就这样,从核心基础层面的MUSA统一架构芯片,到性能强大、可灵活部署的MTT S系列智算加速卡,到高度整合、完整方案的训推一体机,到小型的智算微模块,最终到夸娥千卡集群,摩尔线程提供了全套的全功能GPU产品组合。

这样一来,不同需求的客户,都可以根据实际情况,选择最适合自己的对应层级方案。

夸娥智算中心全栈解决方案,包括底层的以夸娥计算集群为核心的基础设施、中间层的KUAE Platform集群管理平台、最上层的KUAE Model Studio大模型平台,软硬一体开箱即用,一站式方案,一体化交付。

首先在基础设施方面,全功能GPU是最坚定的基石,具备AI加速计算、3D图形渲染、超清视频编解码、物理仿真和科学计算四大计算引擎,在功能上是国内唯一可以对标NVIDIA的全功能国产GPU。

其次是软硬一体,因为与传统GPU从芯片到卡的路径不同,摩尔线程走的是系统级平台路线,不但有千卡规模的算力集群,还有集群管理平台、大模型平台,从而做到软硬结合,以一体化交付的方式,解决大规模GPU算力的建设和运营管理问题。

最后是全栈方案,从底层基础设施,到中间层管理平台,再到上层应用,摩尔线程做到了全面覆盖,具备云全栈能力,能够有效地为千亿参数大模型训练和推理提供强大支持。

总结来说,夸娥智算集群全栈方案有8大核心优势:

- 广泛模型覆盖,支持包括LLaMA、GLM、Aquila、Baichuan、GPT、Bloom、玉言等数十种业界主流的多种大模型的训练和微调。

- CUDA主流生态兼容,可利用摩尔线程代码移植工具Musify,几乎零成本地将CUDA代码自动迁移到摩尔线程统一系统架构MUSA,再快速完成优化,而且完全独立可靠。

- 断点续训,可以实时监测训练任务集群,分钟级发现故障,并自动恢复训练,再加上检查点备份恢复,可以大大降低故障率,并将综合训练效率提升15-50%。

- 大模型分布式训练,支持DeepSpeed、Megatron-DeepSpeed、Colossal-AI、FlagScale等业界主流分布式框架,并融合多种并行算法策略,还支持大模型分布式训练断点续训、分布式推理。

- 推理加速,包含了KUAEModel Studio一体化应用平台、MUSA Serving推理服务软件、MT Transformer分布式推理加速框架、TensorX推理加速框架四大部分,可以有效支持主流大语言模型推理。

- 高性能通信,包括2/4/8卡节点内互连、PCIe和自主研发的MT-Link链路带宽聚合、自研MCCL集合通讯库等,MT-Link带宽高达112GB/s。

- 高性能存储,支持存储数据经RDMA网络读写、GPU Direct Storage、数据读写加速、数据缓存加速、AI训练数据集加载加速、高性能并行文件系统、与外部存储交换冷热数据,等等。

- 集群可靠性与性能,完全可以支持万卡以上大规模GPU集群的运行。

历史无数次证明,越是艰难时刻,越需要国人勇敢地站出来,独立自主,打破封锁,AI算力时代亦是如此。

作为国内率先落地的首个以全功能GPU为底座的全国产千卡千亿模型训练平台,摩尔线程夸娥千卡集群方案实现了软硬设计、性能算力、生态应用的多方面突破,凭借自研软硬架构与开发平台、通用计算路线,具备多方面的独特优势。

尤其是在恶劣的国际环境下,在我国GPU技术相对薄弱的情况下,摩尔线程是最有希望破局的,全功能GPU唯一可以在功能上对标媲美英伟达,尤其是摩尔线程的创始团队基本都出自英伟达,创始人张建中是原英伟达全球副总裁、中国区总经理,不但有着丰富的行业经验、雄厚的技术功底,更能做到知己知彼。

而在技术之外,GPU行业也迎来了政策利好,更有利于实现突围。

比如北京市近期发布的《北京市算力基础设施建设实施方案(2024-2027年)》就明确提出,加快推动核心软硬件产品自主可控,建设自主可控算力技术体系,推动人工智能大模型与自主可控芯片开展适配。

对于采购自主可控GPU芯片、开展智能算力服务的企业,按照投资额的一定比例给予支持,加速实现智算资源供给自主可控。

从千卡高效互连的算力领先,到软硬一体的高度优化,从大模型训练与推理一体化,到高度的稳定性与可靠性,摩尔线程夸娥千卡集群在各个方面都已经拥有成熟的经验,堪称“中国英伟达”,最有希望实现国产自主替代,解决国内AI算力紧缺的难题。

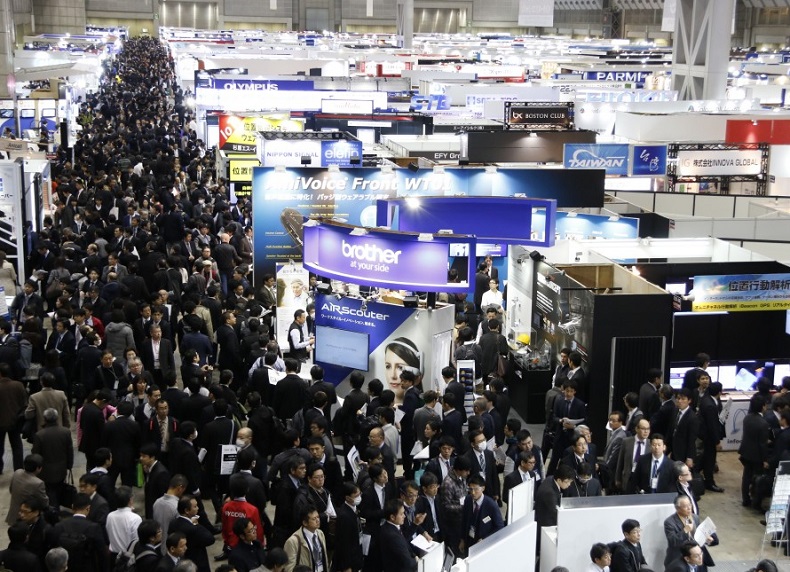

中国电子信息博览会(中文简称:电博会,英文简称:CITE),是展示全球电子信息产业最新产品和技术的专业商贸平台,经过十一年努力,现已成为亚洲极具规模和影响力的电子信息博览会。展会聚焦智慧家庭、新型显示、高端半导体、信创、大数据与存储、特种电子、人工智能、绿色消费电子、基础元器件等行业热点。CITE2025将于2025年4月9-11日在深圳会展中心(福田)隆重举办!展示面积达10万平方米,汇聚全球各地超1500家参展企业,将吸引超8万名专业观众莅临参观。

参考资料:

China Electronics Fair

举办地区:广东

展会日期:2025年04月09日-2025年04月11日

开闭馆时间:09:00-18:00

举办地址:深圳市福田区福华三路深圳会展中心

展览面积:100000

观众数量:70000

举办周期:1年1届

主办单位:中国电子器材有限公司